在本文中,我们将专注于Python中最重要的预处理技术之一 - 使用StandardScaler()函数标准化。

让我们开始吧!!!

需要标准化

在进入标准化之前,让我们先了解规模化的概念。

功能的缩放是使用数据集对算法进行建模的一个必不可少的步骤,通常用于建模目的的数据是通过各种手段获得的,例如:

- 問卷

- 調查

- 研究

- 調查(/community/tutorials/scrape-google-search-using-python-beautifulsoup),等等

因此,所获得的数据包含各种尺寸和尺寸的特征,数据特征的不同尺寸对数据集的建模产生不利影响。

因此,在错误分类错误和准确率方面,预测的结果是偏见的,因此,在建模之前,必须对数据进行规模化。

**这就是标准化出现的时刻。

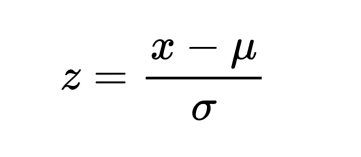

标准化是一种规模化技术,通过将数据的统计分布转换为以下格式,使数据无规模化:

- 平均 - 0(零)**

- 标准偏差 - 1

通过此,整个数据集以零平均值和单元差异为规模,总和。

现在让我们尝试在即将到来的部分中实施标准化概念。

Python sklearn StandardScaler() 函数

Python sklearn 库提供了 StandardScaler() 功能,可将数据值标准化为标准格式。

合成:**

1object = StandardScaler()

2object.fit_transform(data)

根据上述语法,我们最初创建一个StandardScaler()函数的对象,然后使用fit_transform()和所分配的对象来转换数据并将其标准化。

** 注意:** 标准化仅适用于以下数据值 ** 正常分布 **。

使用 StandardScaler() 函数标准化数据

看看下面的例子吧!

1from sklearn.datasets import load_iris

2from sklearn.preprocessing import StandardScaler

3

4dataset = load_iris()

5object= StandardScaler()

6

7# Splitting the independent and dependent variables

8i_data = dataset.data

9response = dataset.target

10

11# standardization

12scale = object.fit_transform(i_data)

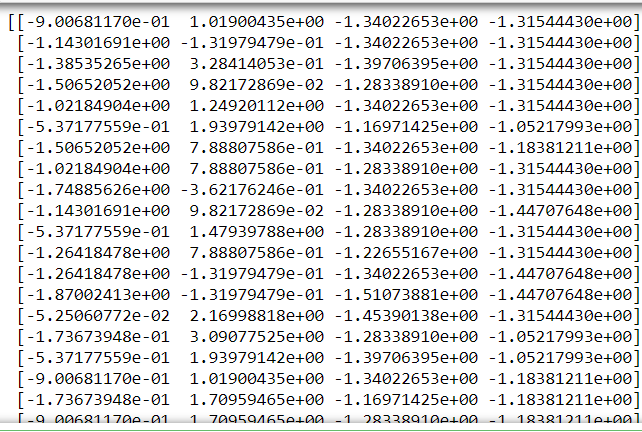

13print(scale)

** 解释:**

我们已经导入了 sklearn 库以使用 StandardScaler 函数 2. 加载数据集. 在这里,我们使用了 sklearn.datasets 库的 IRIS数据集. 您可以找到数据集(在这里)(https://archive.ics.uci.edu/ml/datasets/iris)。 3. 将一个对象设置为 StandardScaler() 函数 4. 按上面所示分离独立和目标变量 5. 使用 fit_transform() 函数将该函数应用到数据集

出发点:**

结论

由此,我们已经到这个话题的尽头. 请自由评论下面,如果你遇到任何问题。

有关 Python 的更多帖子,请留意 @ [Python with JournalDev]( / 社区 / 教程 / Python - 教程) 直到那时,快乐学习!! :)